type

status

date

slug

summary

tags

category

icon

password

大家好,我是易安。

在人工智能基础设施的世界里,常有一种说法:"英伟达打造了围墙花园,让所有人都必须按他们的规则玩游戏。"但今天,我们见证了一个DeepSeek正在这个围墙上开辟新的大门 — DeepSeek的开源之旅进入第四天,带来了两款重量级技术工具:DualPipe和EPLB。

硬件资源榨干到极致 — DualPipe双向流水线技术解析

DualPipe到底是什么?简单来说,它是一种全新的双向并行计算策略,专为大模型训练中的计算-通信重叠设计。根据官方资料,DeepSeek-V3在传统训练方式下,计算与通信的时间比接近1:1,这意味着几乎有一半的时间在等待数据传输 — 这对于昂贵的GPU资源来说简直是暴殄天物。

为了让大家理解这个技术概念,我想用高铁系统来做比喻:

想象你是一个高铁网络的调度员。传统的单向铁路系统中,一列高铁需要完成"上客→出发→行驶→到站→下客"的完整流程才能开始下一趟旅程。在繁忙时段,车站月台会人满为患,而轨道上却可能只有一列车在运行,其他列车只能在始发站等待。

这种资源分配不均的情况,在AI训练中被称为"流水线气泡"。

DualPipe的核心理念相当于设计了一种双向循环高铁系统:在同一条轨道上,允许从两个方向同时发车,并精确控制每列车的运行时刻表。当A站到B站的列车正在中途行驶时,B站已经可以发出开往A站的列车,两列车在不同路段同时运行,最大化了轨道利用率。通过这种双向调度,系统吞吐量可以提升近一倍。

根据DeepSeek公布的实测数据,与传统方法相比,DualPipe将流水线气泡减少到了极低水平,效率提升显著。虽然它需要额外的参数复制(参数量翻倍)和略多的显存占用,但对于追求极致训练速度的场景来说,这是完全值得的交换。

EPLB — 让AI专家协同工作的超级调度器

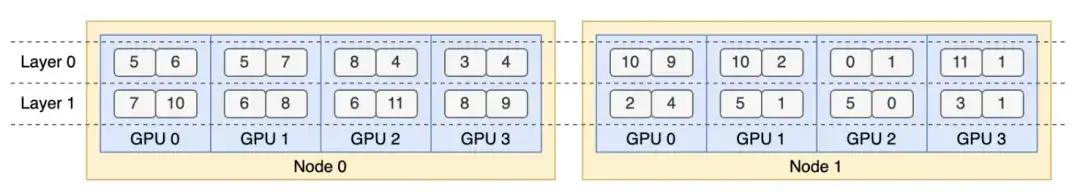

除了DualPipe,DeepSeek还开源了另一个技术杰作:EPLB(Expert Parallelism Load Balancer,专家并行负载均衡器)。

要理解EPLB的价值,我们可以将混合专家模型(MoE)比作一个大型医院的急诊系统:

在繁忙的三甲医院里,各科室专家(心脏科、骨科、神经科等)需要随时待命处理急诊病例。然而,由于各种疾病的发病率不同,心脏科和神经科的专家可能总是忙得不可开交,而其他科室的医生却相对空闲。更复杂的是,某些复杂病例需要多个科室专家协同会诊,如果这些专家分布在医院不同楼层,光是集合就要耗费宝贵的时间。

EPLB就像一个超级智能的医院管理系统:

- 动态人力资源分配:它会分析近期各科室的就诊数据,预测哪些科室将最为繁忙,并临时增派更多专家到这些科室。

- 空间优化布局:它会将经常需要协作的科室(如心脏科和介入科)安排在同一楼层,减少医生奔波时间。

- 负载预测与调整:系统持续监控各科室负载情况,实时调整人力配置,确保医疗资源最大化利用。

这种智能调度策略在大规模混合专家模型训练中尤为重要,EPLB通过优化专家分配和放置,显著提升了训练效率和硬件利用率。

技术开源背后的深层思考

DeepSeek开源这两项技术并非简单的代码发布,而是提供了完整的工程实现和详细文档,任何团队都可以直接应用到自己的项目中。

有趣的是,DeepSeek的这些优化工具虽然表面上是"反抗"英伟达的生态壁垒,但实际上是在英伟达的硬件架构上做出的极致发挥。这种看似矛盾的现象恰恰反映了当前AI基础设施的复杂格局:我们不得不依赖英伟达的硬件,但同时也需要开源社区的力量来突破效率瓶颈。

从FlashMLA、DeepEP到DeepGEMM,再到今天的DualPipe和EPLB,DeepSeek正逐步构建起一套完整的AI系统优化工具链,为大模型训练提供全方位的加速方案。

我的思考:开源之外的战略考量

作为长期观察AI工具发展的内容创作者,我认为DeepSeek的连续开源行动背后有更深层的战略意义。

当我们谈论AI基础设施时,往往聚焦于硬件供应链,但实际上软件层面的优化同样至关重要。DeepSeek此次开源的技术,本质上是在说:"即使我们不能改变芯片架构,我们也能通过软件创新突破硬件极限。"

这种思路对国内AI产业的启示是巨大的。在短期内难以实现硬件完全自主的情况下,我们完全可以在软件层面构建自己的竞争壁垒。DualPipe和EPLB的实际效果证明,通过深度优化,我们可以从同样的硬件中挖掘出更多潜力。

在我看来,DeepSeek的开源策略绝非简单的技术分享,而是一种战略性的生态构建。通过开放核心训练技术,他们正在吸引更多开发者加入其技术体系,形成围绕DeepSeek模型的开发者社区和工具链。这或许是中国AI企业与国际巨头竞争的一条独特路径——不是封闭对抗,而是开放融合。

未来,随着这些优化技术的普及应用,我们或许能看到更多国内团队在有限的计算资源下,依然能训练出世界级的模型。技术的民主化,终将带来创新的爆发。

开源地址:

- DualPipe: https://github.com/deepseek-ai/DualPipe

- EPLB: https://github.com/deepseek-ai/eplb

- 性能分析数据库: https://github.com/deepseek-ai/profile-data-v3r1

我是易安,一位专注AI技术研究的AI超级个体。每天为大家带来前沿AI工具评测和实践经验,用通俗易懂的方式解读复杂的技术概念,👇长按扫码关注,一起探索AI技术的无限可能!

如果觉得我的文章对你有帮助的话,可以帮我点个赞👍或者喜欢❤,让更多跟你一样好品味的人看到这些内容,感谢🙏

- Author:NotionNext

- URL:http://preview.tangly1024.com/article/22ced26c-0da0-81d9-b346-c1ed94efa17a

- Copyright:All articles in this blog, except for special statements, adopt BY-NC-SA agreement. Please indicate the source!